(Imagem: © Yurich84, Getty Images, via Canva.com) -

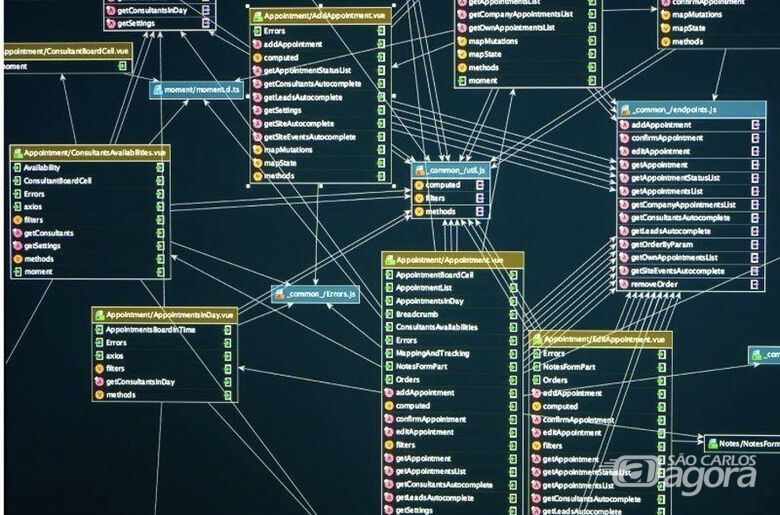

(Imagem: © Yurich84, Getty Images, via Canva.com) - Resultados de pesquisas científicas usadas para prever interações entre proteínas, recomendar medicamentos e até detectar fraudes financeiras podem ser menos confiáveis do que se imaginava. Uma revisão sistemática conduzida por pesquisadores da Universidade Federal de São Carlos (UFSCar) identificou falhas metodológicas recorrentes em estudos que utilizam redes neurais de grafos — um tipo de inteligência artificial voltado à análise de dados conectados em rede e que acumula mais de 40 mil citações desde 2016.

A revisão foi publicada no periódico científico IEEE Access e analisou 84 artigos que aplicam essa técnica ao agrupamento de dados em rede. O levantamento revelou que, em 69 desses trabalhos (82% do total), os algoritmos foram validados sempre com as mesmas três bases de dados: Cora, CiteSeer e PubMed. Para os pesquisadores, essa prática compromete a generalização dos resultados.

“É como se dezenas de laboratórios testassem um medicamento sempre nos mesmos pacientes. Os resultados podem parecer sólidos, mas dizem pouco sobre o desempenho em condições reais”, explica Guilherme Henrique Messias, doutorando em Ciência da Computação pela UFSCar e autor principal do estudo.

Segundo Messias, há uma confiança excessiva em poucos conjuntos de dados. Além disso, essas bases foram originalmente desenvolvidas para tarefas de classificação supervisionada e posteriormente adaptadas para métodos de agrupamento, o que pode distorcer as conclusões. Outro ponto crítico é que elas não conseguem representar cenários reais com fidelidade.

“Em redes sociais, por exemplo, há poucos perfis com milhões de seguidores e muitos com poucos seguidores. Esse comportamento é muito diferente do observado em redes de citações acadêmicas, que são a base desses conjuntos de dados”, destaca o pesquisador.

O artigo também é assinado por Tiago Gonçalves Botelho, do Departamento de Computação da UFSCar e professor do Instituto Federal do Sul de Minas (IFSULDEMINAS – campus Muzambinho); Sylvia Iasulaitis, professora do Departamento de Ciências Sociais da UFSCar e líder do grupo Interfaces; Murilo Coelho Naldi, professor do Departamento de Computação; e Alan Demétrius Baria Valejo, também professor da UFSCar e vice-líder do Interfaces.

A pesquisa contou com financiamento da Coordenação de Aperfeiçoamento de Pessoal de Nível Superior (Capes), da Fundação de Amparo à Pesquisa do Estado de São Paulo (Fapesp) e do Conselho Nacional de Desenvolvimento Científico e Tecnológico (CNPq).

Metodologia e nova taxonomia

Para chegar aos 84 artigos analisados, os pesquisadores partiram de um universo de 496 publicações encontradas nas bases Scopus e Web of Science. Após a aplicação de 20 critérios de inclusão e exclusão, a seleção final foi realizada de forma independente por dois pesquisadores, com taxa de concordância considerada substancial (coeficiente kappa de 0,75).

Com base na análise, o grupo propôs uma nova taxonomia para organizar os algoritmos de agrupamento em grafos. Os métodos foram divididos em duas grandes categorias: modelos de incorporação de nós, que transformam os dados em representações vetoriais antes do agrupamento, e modelos profundos, que integram o processo de agrupamento ao aprendizado do algoritmo. Cada grupo inclui subcategorias específicas, como técnicas adversariais e métodos baseados na divergência de Kullback-Leibler.

A classificação busca preencher uma lacuna existente na literatura científica, já que revisões anteriores agrupavam métodos distintos em categorias amplas, dificultando comparações e a identificação de limitações específicas.

Falta de reprodutibilidade

Outro problema recorrente identificado pela revisão foi a falta de transparência experimental. A maioria dos trabalhos não disponibilizava códigos ou repositórios abertos. “Encontramos muitos experimentos que não eram abertos, sem indicação clara de repositórios ou arquivos”, afirma Messias.

Essa ausência dificulta a reprodução dos resultados. Em algumas tentativas de replicação, os pesquisadores obtiveram resultados bastante diferentes dos apresentados nos artigos originais, o que levanta questionamentos sobre a confiabilidade das conclusões publicadas.

Além disso, apenas dois dos 84 estudos analisados abordavam a definição automática do número de grupos a serem identificados nos dados. Na maioria dos casos, essa quantidade precisa ser informada previamente pelo usuário — uma informação que, na prática, geralmente não está disponível.

“Se você define três grupos, mas os dados naturalmente formam quatro, o resultado será ruim”, exemplifica o pesquisador.

Aplicações e próximos passos

Apesar das limitações, a revisão também evidencia o potencial das redes neurais de grafos. Os estudos analisados relatam aplicações em áreas como diagnóstico de Parkinson a partir de redes cerebrais, detecção de fraudes financeiras, análise de redes criminosas, planejamento de transporte urbano e identificação de comunidades em sistemas biológicos.

Para superar os gargalos identificados, os pesquisadores apontam como alternativa o desenvolvimento de bases de dados sintéticas, capazes de simular cenários reais de forma controlada. “Isso abriu uma brecha importante para pesquisas em criação de dados artificiais”, afirma Messias, que pretende aprofundar essa linha em seu doutorado.

O estudo também chama atenção para a ausência de modelos baseados em transformers — arquitetura dominante no processamento de linguagem natural — aplicados a tarefas de agrupamento em grafos, apontando uma frente de pesquisa ainda pouco explorada.

Mais informações sobre as atividades do grupo Interfaces/UFSCar estão disponíveis no site interfaces.ufscar.br e no Instagram @interfacesufscar.